Le casque sur les oreilles, un ingénieur du son donne des indications à son perchiste. Il se concentre sur son écoute, fait quelques signes. Le micro est déplacé, on le réoriente. Observant la scène, le profane –celui qui n’a jamais tenu un micro– se demande si ces gens du son finalement n’en rajoutent pas un peu. Pourquoi tous ces réglages pointilleux ?

Aujourd’hui tout le monde (ou presque) fait de la prise de son avec… son téléphone portable. Le résultat n’est toutefois pas terrible : « j’entends rien… qu’est que c’est que ce boucan derrière toi… ? Mais où tu es, là ?» dit l’un, « attends je vais à côté, au calme, je ne t’entends pas non plus » dit l’autre… C’est que ladite prise de son se fait en monophonie, avec un seul microphone, et sa restitution avec un seul écouteur, un écouteur faiblard qui n’arrive pas à couvrir le bruit ambiant… Alors on tend l’oreille, on se cale sur l’interlocuteur, sans se rendre compte que l’on parle trop fort dans l’espoir (tout à fait vain) d’obtenir un meilleur niveau en retour, soit une plus grande intelligibilité… Avec deux écouteurs bien isolés, la situation s’améliorerait complètement, la monophonie deviendrait presque plaisante, mais qui le sait ?

Moins nombreux sont les possesseurs de caméscopes, mais ils ne sont pas rares pour autant. Des caméscopes automatiques qui se chargent du point, de la lumière et du son. La prise de son –stéréo– se fait sans casque et sans questions particulières. Les résultats obtenus sont forcément décevants : discontinuité sonore de plan à plan, réverbération excessive, bruits ambiants exagérés, plans sonores toujours très flous ou lointains, bruit du vent, intelligibilité réduite, écoute fatigante… « Le son n’est pas bon du tout ! C’est bizarre, l’image est excellente » s’étonne-t-on. Avec une perche et un micro bien placés, avec un casque de contrôle et une modulation bien réglée les choses commenceraient à prendre de l’allure. On s’approcherait évidemment de la pratique professionnelle, laquelle a une autre histoire.

C’est en 1930 que le son gravé sur cire rejoint le bord de la pellicule. Jusqu’alors images et sons naviguaient séparément, faisaient bande à part, en quelque sorte, à la radio et au cinéma. Avec le parlant, les voilà réunis, mais le retard technique et ergonomique du son se fait entendre : microphones lourds, camions pour sons optiques, bande passante limitée, aigus agressifs. Pour le documentaire, c’est l’ère du travail en studio, du bruitage en auditorium, des commentaires enregistrés en cabine. Il est difficile en effet de transporter caméras blimpées et camions-sons sur le grand plateau du réel, tandis qu’il est encore facile de porter une Paillard ou un Caméflex jusqu’au fond de la jungle tropicale, ou à l’intérieur d’un conflit social. A la sortie de la deuxième guerre (1950), les progrès de l’électronique et l’arrivée de la pellicule magnétique vont permettre une finesse plus grande, un son plus doux, plus dynamique, plus stratifié, mais la mobilité de l’appareillage restera limitée.

Daniel Craig, acteur incarnant James Bond dans la série Casino Royale, en tournage aux Bahamas

C’est seulement avec la venue du transistor (et de son alimentation à piles) qu’un magnétophone presque léger, en tout cas portatif, va s’imposer. Conçu par Kudelski en 1958, le Nagra III devient l’instrument majeur de la prise de son : on peut enfin aller chercher les silences, les fonds d’air, les ambiances, les effets, les voix et les musiques aux quatre coins du monde, comme les opérateurs des frères Lumière l’avaient fait soixante-trois ans auparavant. Des paroles jusqu’alors inouïes sont enfin entendues, enregistrées, restituées. Des paysages naturels, des scènes de rue, des guerres, des chuchotements d’amoureux, des sons d’usine, des manifestations, des danses rituelles… Bien avant que la mini-DV ne s’empare à son tour, en synchronisme obligé, d’images et de sons automatiquement liés, les explorateurs du sonore avaient saisi, en plaçant leurs micros au bon endroit, des scènes auditivement claires, expressives et parlantes, savamment composées depuis un ou plusieurs points de captation.

Tous ces pionniers du tout terrain avaient appris que le choix du point d’écoute –on devrait dire point d’ouïe, par analogie avec point de vue– est décisif. Que le suivi souple et fluide –à la perche– des sources sonores en mouvement garantirait une image stabilisée en timbre, volume ou plan sonore, et de la sorte acceptable par l’auditeur, malgré la monophonie. Que la recherche de lieux plutôt silencieux permettrait d’ajouter après coup des sons seuls, des ambiances et des effets qui s’ajusteraient au mixage. Connaissant le rendu monophonique de leur outils, les preneurs de son des années soixante inventèrent ainsi les procédures instrumentales précises qui rendirent le son vraisemblable, c’est-à-dire à la fois proche et différent de ce que nous entendons. Suffisamment semblable, pour être cru et reconnu, suffisamment différent pour aller vers une écriture sensible et expressive du sonore.

Du microphone à l’oreille

Le casque sur les oreilles, un ingénieur du son donne des indications à son perchiste. Il se concentre sur son écoute, fait quelques signes. Le micro est déplacé, on le réoriente. A quelques centimètres près, le rendu change, le rapport entre les sons évolue, la mise en acoustique n’est plus la même. On cherche un nouveau plan sonore, un emplacement optimal. On évalue la lisibilité, on teste une voix, on atténue un bruit ambiant. Observant la scène, le profane –celui qui n’a jamais tenu un micro– se demande si ces gens du son finalement n’en rajoutent pas un peu. Pourquoi tous ces réglages pointilleux ?

Placés au même endroit, le tympan de l’oreille et la membrane d’un microphone reçoivent à peu près les mêmes vibrations. L’un et l’autre recueillent de fait les ondes sonores disponibles en ce point de l’espace. On devrait plutôt parler de « magma sonore » puisque que les ondes y arrivent ensemble, mélangées comme une addition. Usons d’une métaphore arithmétique. Si je dis par exemple « résultat : 88 ! ». Comment savoir si 88 est la somme de « 80 + 8 » ou de « 22 + 46 + 20 » ou encore de « 13 + 27 + 35 + 23 » ? Comment retrouver le détail de l’addition si je ne dispose que du résultat ? Comment retrouver et départager les sources sonores si je ne perçois que leur somme ? Et c’est justement ce mélange qui, sans précautions, est diffusé par le haut-parleur de restitution, dans les séances familiales autour du caméscope. Inaudible, on dirait ! Le cerveau ne peut tout simplement plus choisir et trier parmi les vibrations émises. Et pourquoi ? Parce que l’espace sonore environnant a été compacté et simplifié à une seule information (au point de capture), et restitué un peu plus tard de la même façon (au point de diffusion).

Allons dans un café à peine bruyant, fermons les yeux et bouchons-nous une oreille, celle tournée vers la scène sonore : nous voilà transformés en microphone omnidirectionnel ! On ne comprend plus rien, la réverbération est excessive, l’ambiance démesurée, les percutantes exagérées, etc… Ouvrons les deux yeux et les deux oreilles en nous retournant vers la scène : les sons ambiants se calment, reprennent leur place exacte en distance et en azimut. Refaisons l’expérience plusieurs fois de suite –écoute monaurale puis binaurale– l’effet est saisissant ! L’intelligibilité est retrouvée, on peut même suivre une conversation rapprochée en se servant éventuellement de la lecture faciale et labiale. Le cerveau, nanti de deux informations différentes (oreille gauche et oreille droite) peut nettoyer automatiquement l’espace acoustique (BMLD ou binaural masking level difference), dompter les bruits ambiants en quelque sorte, et écouter volontairement la source intéressante (ILD ou intelligence level différence), en lui donnant présence et précision1.

On voit ici à quel point l’écoute humaine est différente de la captation microphonique. Deux fois différente : pas de nettoyage BMLD (les lointains rappliquent, la réverbération augmente, les bruits sont très masquants) ; pas de focalisation ILD (la source intéressante n’augmente ni en précision, ni en présence). Pour pallier ces manques, il faut chercher des lieux plus silencieux –moins bruyants en tout cas– et s’approcher très nettement des sources, comme le font les perchistes. Entrer en proximité, écouter ce que cela donne, ajuster la distance et l’axe jusqu’à obtenir une image plausible, et peut-être même fort belle de la source.

Chaque emplacement microphonique est en effet le centre d’un mixage physique entre les ondes directes issues des différentes sources en activité et les ondes indirectes rabattues par les parois de la salle : un tel mixage restitue toujours un enchevêtrement de sons, une sorte de version à la fois objective et cafouilleuse de la pression acoustique régnant en ce point. Il s’agit donc de choisir la bonne version en tendant la perche comme on a tendu l’oreille.

C’est le seul moyen connu pour reconstruire une perspective sonore, à savoir : affirmer un son principal, atténuer les sons annexes trop insistants, récupérer les détails significatifs, jouer des effets de masque entre les sons, régler le net et le flou, étager la profondeur…etc. C’est pourquoi les microphones implantés dans les caméscopes grand public ne sont pas d’un grand secours. Le réalisme du microphone n’est pour ainsi dire qu’un réalisme technologique, très en dessous du réalisme épuré de l’écoute binaurale. Qui donc pourrait se passer du ou de la perchiste ?

Plus compliqué : la chaîne auditive…

Un simple bruit de pas peut déclencher une réaction émotive (jubilation, peur soudaine), voire une action déterminante (approche agressive, dissimulation propice, élan salvateur), ou même une totale indifférence. Il en va de même pour tous les sons, petits et grands, forts ou faibles. Un silence glacé, un cri, des soupirs, une ambiance chargée et tendue, une voix savoureuse ou mordante, un déclic soudain : dans la vie, l’écoute des bruits et des paroles engage parfois la totalité de l’être.

Les documentaristes ont très tôt compris l’intérêt (esthétique, scénographique, dramaturgique) de faire jouer le in et le off, le manque-à-voir et le donné-à-entendre, c’est-à-dire l’imaginé et le perçu. La mise en scène auditive, dans le hors champ de l’écran, travaille les représentations et les attentes du spectateur –séquence après séquence– tandis qu’à l’intérieur du cadre –plan après plan– elle ajoute aux mouvements de l’image son énergie intermittente, certes, mais toujours expressive.

En emmenant l’écoute au delà d’un supposé réalisme, en se déliant par exemple du naturalisme prêté au son synchrone ou à la captation monophonique du son direct, la bande-son est devenue plus que jamais le lieu d’une écriture, d’une composition. Qu’ils soient diffusés en mono ou en multicanaux, les sons (voix, bruits et ambiances) prennent place tout autour, dans le géométral de la scène : les sources multiples du sonore entourent virtuellement le spectateur pour toute la durée de la séquence2.

Tandis que l’écran persiste droit devant, comme un grand rectangle lumineux accueillant la suite changeante des plans, le monde auditif est déjà installé tout autour : une multitude de cercles concentriques et obscurs[[C’est aussi là l’intérêt du découpage cinéma. Tantôt obscures (en off), tantôt mises en lumière (en in) les sources sonores sont entrevues successivement : sur le mode imaginaire, sur le mode mémoriel, sur le mode visuel et auditif.]], possiblement peuplés de sons proches ou lointains, synchrones ou asynchrones par origine, mais synchrones par destination.

Il est peut-être nécessaire, avant d’aborder les données instrumentales et le projet scénographique, –comme le fait concrètement Daniel Deshays dans sa communication– de faire un détour par les différentes étapes du traitement auditif, pour prendre la mesure justement des implications diverses résultant des différences entre captation microphonique et écoute binaurale.

Longtemps limitée à la physiologie, l’étude des phénomènes sonores s’est bien élargie. Elle s’étend désormais à d’autres domaines –perceptifs, esthétiques, cognitifs– jusqu’à expliquer le tri entre le ressenti subjectif, si différent d’un spectateur à l’autre, et les perceptions relativement invariantes, sur lesquelles le cinéaste s’appuie intuitivement. Mais là, çà se complique sérieusement.

a/ les sources

Au plan acoustique, les sources sont des émetteurs, omnidirectionnels dans le grave, plutôt directifs dans l’aigu. Intermittente, continue ou isolée, l’émission reflète nécessairement une énergie en mouvement : naturelle (tempête, bords de mer…), sociale (circulation, travaux…) ou domestique (bouilloire, sonnerie…). La plus intéressante est l’activité corporelle. D’ordinaire souple et silencieuse, l’énergie musculaire se fait entendre à travers un son plus ou moins intense (entrechoc, manipulation d’objets, déplacement…), lequel déclenche en retour l’écoute causale. On voit tellement bien de quoi il s’agit que le matériau sonore –grain, masse, contour, hauteur, timbre– est quasi oublié dans le « pourquoi » de son émission : l’intention d’un geste est comprise à travers le déploiement temporel du son.

Epais ou léger, grave ou aigu, lisse ou grenu, le son marque pourtant l’auditeur par son emprise sensorielle pour mieux figurer la chaîne causale d’où il procède. Subito forte, poco a poco decrescendo, staccato, subito piano, sforzando, etc… De l’énergie s’entend dans le profil temporel, dans l’évolution du timbre et des tessitures. Forme faible –furtive, fondue dans l’ambiance– ou robuste –résistante au bruit, charpentée– le son appelle à la reconstruction des données, à la remise en jeu d’un déjà connu catégorisé (le crissement des pneus, par exemple), dans une situation précise (ce coup de frein, dans ce virage).

Les instants sonores, successivement articulés (dérapage, choc de tôles, cris), s’assemblent alors en en figure temporelle plus ou moins longue, figure qui se précise ou se perd, s’affirme ou s’interrompt, non sans avoir imagé ses hypothèses, en amont (causes), ou en aval (conséquences).

Cette figure temporelle plus ou moins définie (l’accident, les blessés) appelle souvent une confirmation visuelle, une validation détaillée de l’événement (les passagers, le type de voiture, la cause de l’accident). On pourrait ainsi différencier les sons « familiers » déjà réglés par l’ordre social ou les habitudes familiales (la circulation automobile, l’aspirateur) d’avec les sons « en infraction » (insultes, klaxons, bris de vaisselle…), infractions qui perturbent ou endommagent cet ordre.

b/ la propagation

En tant que source active, chaque objet sonore dispose d’une portée –d’un périmètre d’atteinte– qui dépend de la puissance et de la directivité de l’émission, mais aussi des obstacles rencontrés, et même de la direction du vent. Jusqu’où porte la voix ? Si le niveau diminue généralement avec le carré de la distance parcourue (perspective géométrique en 1/d2), la portée reste relativement plus importante en champ clos –dit semi-réverbérant– à cause des repliements et des rebonds sur les parois des salles. Au lieu de se perdre dans la distance, l’énergie se replie et se diffuse invisible, plusieurs fois rabattue par les murs, jusqu’à contourner les obstacles, s’il s’en trouve. Tandis qu’en champ libre –en plein air– la décroissance est très rapide, en raison des volumes rencontrés et/ou de l’absorption par le sol. Par ailleurs, le son s’amollit avec la distance, perd de son tranchant, de sa rugosité (une sorte de perspective aérienne, naguère décrite par Léonard de Vinci comme une décoloration des lointains, une indistinction croissante des détails).

Telle se présente provisoirement la perspective auditive, avec un double aspect semblable à la perspective visuelle : à la fois perspective hiérarchique, liée à la puissance des sources (et non pas à l’encombrement spatial) et perspective de profondeur, réglée par les éloignements. Un objet sonore tout proche, de taille imposante, peut rester quasi-silencieux, alors qu’un objet lointain, peu encombrant, peut se révéler très sonore. Silence, fond d’air, sons lointains et peu définis, petits bruits légers, ambiance soutenue, brouhahas, vacarme, etc… constituent autant de représentations subjectives de la puissance, mais ce sont là des indications très relatives, fortement modifiables par la proximité ou l’éloignement. Et pourtant ! Un camion qui s’éloigne ne devient pas une camionnette ni même un « camionniculet » ! C’est que la mise en espace –et pour cela, deux oreilles et un cerveau ne sont pas de trop– rétablit la masse originelle d’un son, lui donne son poids véritable, en même temps que sa provenance exacte, malgré les fluctuations de l’image reçue.

Nous sommes tellement habitués à stabiliser le monde auditif, à l’objectiver, en quelque sorte, que nous oublions volontiers ceci : chaque emplacement d’écoute est un point de mixage accueillant les différentes vibrations aériennes pour les mélanger par ordre d’intensité relative. Même si parfois on est obligé de s’écarter pour échapper à un bruit gênant (chute d’eau, moteur, marteau-piqueur), pour atténuer le bruit trop intense qui fatigue l’oreille et ruine l’écoute intelligente. Instinctivement, sans même la connaître, nous faisons jouer la loi en 1/d2 qui, en quelques mètres seulement fait chuter le son gênant d’une dizaine de décibels.

En réalité, le monde auditif n’est ramené au silence que par la déperdition aérienne des vibrations, soit par la décroissance due à l’éloignement. Dissipation que l’on observe déjà avec les ampoules électriques, qui, dans l’obscurité de la nuit, n’éclairent plus guère au delà de quelques dizaines de mètres3. Cette constatation est amplifiée par l’effet de masque propre à l’audition, effet qui met les sons en concurrence au plan de l’intelligibilité, malgré le démasquage binaural (BMLD) précédemment évoqué : certains sons s’enfouissent ou émergent subitement, sans lien évident avec la distance, mais en relation directe avec l’environnement immédiat, plus ou moins masquant4. Avec le microphone, faute de démasquage binaural (BMLD), la concurrence entre les sons va augmenter terriblement, et c’est ce qui fait que le point de captation –spatial, temporel– est encore plus décisif.

point d’écoute – on devrait dire point d’ouïe, par analogie avec point de vue

c/ l’oreille

Les différences de captation (entre oreille gauche et oreille droite) sont importantes. La tête fait de l’ombre aux fréquences aiguës (différence d’intensité, selon l’angle d’arrivée) tandis qu’elle introduit pour les graves un retard (différence de temps, selon l’azimut). Seule une source placée droit devant annule les différences gauche/droite. Par ailleurs, les nombreux replis de la conque externe effectuent un ”filtrage en peigne” (de 3 à 15 kHz) qui varie avec la provenance des sources5. Les petits bruits secs, riches en aigus, sont ainsi très facilement localisés. En outre, le conduit auditif accentue –tel un tuyau résonant– les fréquences proches de 2,5 kHz6. L’ensemble de ces dispositions est connu sous le nom des « fonctions de transfert relatives à la tête » (HRTF, head related transfert functions).

C’est donc grâce à ces différences de capture que le cerveau peut reconstituer l’espace sonore à l’entour. Mais cet espace, irrégulièrement et intermittemment habité, est beaucoup moins précis et moins défini que l’espace visuel continûment disponible, aussi longtemps qu’il y a de la lumière ! Que dire des vides auditifs, des longs silences ou des sons brefs, séparés par de longs intervalles muets ! Il n’empêche : le son dynamique s’exprime sur dix octaves, de ppp à fff (contraste moyen : 1 à 20000), tandis que l’objet visuel éclairé s’exprime seulement par son albedo coloré (contraste maximal de 1 à 20). Conséquences : le cadreur règle son diaphragme et n’y touche plus durant la prise ; l’ingénieur du son, au contraire, surveille sans cesse ses niveaux et joue souvent du potentiomètre pour éviter toute sous ou surmodulation, aidé du perchiste qui approche ou éloigne son micro.

Au demeurant, l’appareil auditif procède de la même manière : la chaîne des osselets intervient pour relever un niveau trop faible (tendre l’oreille) ou pour protéger des éclats sonores les fragiles cellules de l’oreille interne. Le système agit de la sorte à la manière d’un compresseur limiteur, d’un sas de sécurité filtrant les crêtes des stimuli. Les vibrations peuvent être alors reçues par le limaçon cochléaire pour être étalées sur la membrane basilaire et traduites aussitôt en influx nerveux.

Les vibrations entrantes se propagent en travelling d’onde sur cette membrane, de 32 mm de long, aux propriétés mécaniques étonnantes : souple et lourde à l’extrémité libre, elle est au contraire légère et raide à l’attache. Selon la théorie couramment admise, les différentes fréquences se trouvent ainsi étalées tout du long, en une suite de résonances localisées. Chaque fréquence vient se positionner à une place attitrée, réalisant une tonotopie (tonos, ton ; topos, lieu) : ce n’est donc pas l’espace qui est étalé sur la membrane, mais bien la hauteur des sons. 3500 cellules spécialisées (munies de cils vibratiles), y effectuent alors, point après point, la traduction électrique de l’intensité.

A remarquer : cette transduction n’est pas linéaire, mais logarithmique.

Elle comprime les fréquences en octaves et les intensités en sonies. De plus, la captation favorise le haut médium et bas aigu (de 800Hz à 4000Hz) tout en défavorisant les graves (surtout aux faibles niveaux, comme le montrent les courbes dites isosoniques). Ainsi un camion qui s’éloigne sur la route s’affaiblit en intensité tout en changeant de timbre : il perd nettement en basses et en aiguës extrêmes (le timbre se rétrécit par les extrémités du spectre). A bonne distance, ne subsistent que les fréquences médiales. L’éloignement s’entend aussi par la décoloration de l’image de référence.

En outre, la membrane de l’oreille interne, en se déformant localement sous l’influence d’un son intense, a tendance à ignorer d’autres vibrations moins intenses, à la fois cachées et absorbées par la déformation principale, faute de sélectivité suffisante. L’effet de masque efface de la sorte tous les sons faibles ou moyens, placés immédiatement au dessus du son fort. D’où ce paradoxe : plus un son est fort et moins il y a de choses à entendre ! L’audibilité de chaque oreille ne s’appuie donc que sur l’enveloppe dynamique instantanée résultant de l’onde propagée sur la membrane : on n’entend jamais le spectre objectif d’une source, avec toutes ses harmoniques (le timbre au grand complet), mais seulement l’ensemble des harmoniques émergentes, non masquées7 (soit le timbre apparent, celui qui nous importe).

Au total, les soixante dix mille fibres du nerf auditif (au lieu des six millions du nerf optique) acheminent les signaux nerveux vers le cortex. Si le sonore représente quelque chose, même approximativement, c’est forcément en prenant un peu de temps –sur un mode séquentiel– et non pas instantanément –sur un mode massivement parallèle– comme dans la vision, mieux équipée de ce point de vue.

d/ la perception

Différents « modules » reprennent le traitement auditif, au plan neuronal. Trois grandes fonctions semblent requises avant toute identification des sources sonores.

1/ L’externalisation : les sons sont resitués à leur place exacte, dans le champ objet environnant (en distance et azimut). Sans cette externalisation, le son resterait collé aux tympans, comme une sensation tactile ! Les différences interaurales d’intensité et de temps sont en réalité transformées en espace concret de localisation et d’action. Et comme l’espace auditif reste stable, quels que soient les mouvements de la tête, tout indique que les mouvements corporels sont pris en compte pour compenser les fluctuations (∆i, ∆t) entraînées par la réorientation de la tête et du cou.

2/ La fusion et la fission : les sons initialement mélangés sur les membranes cochléaires se dégroupent et se séparent pour former des entités différenciées, des sources localisées, intermittentes ou continues. En chacune d’elles, les instants successifs se regroupent néanmoins pour former un flux (un continuum temporel). La fission sépare les sons (spatialement), tandis que la fusion les assemble (temporellement) en profil unifié. Et cela d’autant plus clairement que l’attention y est préparée. On pense aux théories de la forme (Gestalt-theorie), appliquées cette fois à l’audition.

3/ L’extraction des indices auditifs : pour identifier et reconnaître un son, il faut pouvoir extraire certains traits pertinents significatifs. Les uns relèvent de l’enveloppe temporelle (profils d’attaque ou d’extinction, amplitude, allure, durée), les autres du contenu spectral (densité, hauteur et position des formants, fluctuations du spectre). Cependant le monde réel n’est pas directement audible en tant que tel. Il se reflète dans la conscience en qualia, sorte de sensations élémentaires dont le regroupement combiné aboutit à la figure auditive, à la fois image (par ses qualia combinés) et objet (de par sa reprojection exacte dans l’espace-temps). Ainsi la masse, le profil, la hauteur, le grain, le timbre –critères schaefferiens8 – semblent appartenir à l’objet spatialisé, alors qu’ils ne sont que les transcriptions phénoménales des vibrations parvenues aux tympans !

Autrement dit, le cerveau construit en interne des sensations qui se trouvent aperçues en externe, à l’emplacement exact de la source émettrice. Ces transcriptions semblent néanmoins plutôt robustes et assez bien corrélées aux propriétés mécano-acoustiques de l’objet sonore : percussions, frottements, oscillations, résonances.

Selon les neurosciences, il apparaît aujourd’hui que l’extraction des indices procède de deux sortes de fonctions complémentaires : l’une ausculte le profil temporel, l’autre le timbre. Cette dualité « contour-matière » n’est pas sans rappeler la vieille distinction « morphê-hulê » chère aux philosophes de l’antiquité. Plus clairement, le cortex moteur examine le profil dynamique, la masse temporelle évolutive et l’énergie mise en jeu, tandis que le cortex auditif s’intéresse au timbre, au grain, à la couleur et à l’emplacement des sons.

Il y a une origine à ce double parcours : tous les sons que nous produisons –et que nous entendons, ipso facto– sont corrélés à notre activité motrice : la marche, l’effort musculaire, le maniement d’outils, et bien entendu, la voix, le cri, le soupir.

Le geste ordinaire et familier et le bruissement qui en résulte se connaissent, sans mobiliser la moindre dépense consciente. Ils peuvent s’ajuster l’un à l’autre, dans une sorte de préconscient, sans qu’on y prête trop attention. En d’autres termes, le cortex pré-moteur prépare –silencieusement– les actes voulus tandis que le cortex auditif écoute –discrètement– le résultat et ajuste –c’est une routine– l’intention motrice. L’oreille et la voix se connaissent aussi très bien, mais intérieurement, sans avoir besoin de passer non plus par la conscience. Le profil d’effort (respiration, articulations) et le profil d’intensité (accents, nuances) se régulent mutuellement, jusqu’à obtenir –spontanément, dira-t-on– l’intonation et le phrasé recherchés, la portée et la hauteur désirées.

Si le ton, les accents, le rythme d’un propos sont aussi parfaitement saisis par un auditeur, c’est surtout parce qu’ils correspondent à des gestes vocaux déjà vécus et mémorisés, c’est-à-dire à des profils d’expression déjà éprouvés au moment de parler.

Une récente théorie (TMPP ou théorie motrice de la parole perçue) énonce que la perception de la parole ne doit pas être recherchée seulement dans la “surface acoustique” des mots, mais aussi dans la structure articulatoire sous-jacente. La chaîne parlée tient en effet en une série de passages : du geste intentionnel à la commande motrice, de la commande motrice aux déplacements d’articulateurs (langue, mâchoires, lèvres), avec pour résultat final une parole. Il s’agit alors, pour retrouver les gestes intentionnels à partir du son proféré, de faire le chemin inverse, c’est-à-dire de faire dépendre la reconnaissance vocale tant du cortex prémoteur, memento-agenda de gestes vocaux déjà éprouvés, d’articulations intentionnelles apprises, que du cortex auditif, répertoire de syllabes et de vocalisations familières9.

Il en va de même de tous les sons issus de l’activité corporelle, et plus précisément de ceux issus des pratiques consolidées : doublement mémorisés, à la fois sensoriels et moteurs, ces sons ne souffrent pas la moindre approximation de timbre ou de jeu, car toute formule acoustique inexacte ou artificielle serait confrontée à la précision avérée de la mémoire corporelle du mouvement, à laquelle se rattache la justesse et la vérité de nos actes, qu’ils soient volontaires ou involontaires. Cela me fait penser à ce que dit Daniel Deshays à propos d’Alain Cavalier : le cinéaste est allé chercher des gens de métier (il s’agit de bouchers et de photographes, recrutés à l’ANPE) pour les faire jouer dans son film Libera Me, sans doute pour être le plus juste possible, tant au niveau de l’image que des sons.

On pourrait suggérer alors une autre façon de classer les sons : il y aurait ceux –très précis– qui entrent dans l’expérience sensori-motrice (tactile, manuelle, musculaire); ceux –moins évidents– qui se rapportent à des sources vues et entendues mais sans écho particulier dans une pratique ; d’autres encore, qui ne renvoient qu’à une expérience auditive (sons nocturnes ou inaccessibles à la vue) ; ceux , enfin –inouïs ou inconnus– qui convoquent un imaginaire fondé sur l’association ou la ressemblance.

Une fois identifiés, les indices auditifs –acoustiques et/ou moteurs– accrochent nécessairement une représentation déjà catégorisée dans le « pictionnaire » des sons rattachés à une image. Le déjà connu rapplique sur le perçu, en une sorte de raccourci rapide à usage d’explication immédiate. Il faut pourtant aller plus loin que la simple identification générique, le schéma-type. L’image générique (un avion, un chien, une manif) reste insuffisante pour établir la chaîne causale, cerner l’objet dans sa singularité10. Il y a lieu de préciser, compléter, élucider. C’est alors que la vision relaie l’audition, par ajustements successifs du regard ou même dès le premier coup d’œil, si la convergence des informations est assez forte.

e/ l’attention

L’ouïe a cette faculté originaire de protéger l’être vivant, de guetter les modifications infimes du donné sonore –silence ou bruit soudain, pas dans les feuilles, pas suspendu puis relancé– ne serait-ce que pour « rafraîchir » la mémoire spatiale immédiate (la présence à soi du monde) ou entretenir la question vitale –Quoi ? Où ?– ce qui évite par exemple de se faire écraser en traversant la rue. L’écoute « protective » déclenche une réaction d’orientation en direction de l’intrus auditif, afin de voir et d’entendre plus clairement la source/objet qui surgit.

Au demeurant, cette activité involontaire, automatique presque, n’empêche nullement d’autres facultés auditives d’opérer au niveau le plus central de l’activité consciente et préconsciente. Le comportement humain perdrait en effet toute cohérence s’il devait se rattacher, tel une girouette ou un moineau agité, à une imprévisible succession de sollicitations externes, dans un enchaînement sans fin de réorientations réflexes obligées.

Aussi bien l’attention auditive préfère choisir, concentrer sa puissance éclairante sur tel ou tel secteur de l’espace, pour mieux isoler l’objet écouté. Un orateur, de la musique au loin, un petit bruit insolite, l’approche d’un pas connu. L’écoute volontaire sélectionne sa cible, la rehaussant en netteté, avec une présence accrue. Corrélativement, les autres secteurs sont comme relégués en sons d’ambiance, lesquels, lissés de leurs transitoires, nivelés en dynamique, paraissent moins présents.

La conscience attentionnelle, en s’assignant un son à écouter, se hisse de la sorte au-dessus d’une perception directionnelle : le point d’écoute est mentalement centré, alors que l’ambiance est provisoirement rejetée hors de toute visée localisante.

On ne peut du reste écouter qu’une chose à la fois. L’écoute intelligente (ILD), comme le regard, ne peut s’appliquer qu’à un secteur limité de l’espace –une quarantaine de degrés, au maximum– car il est impossible de couvrir d’attention éclairante les 360° qui nous entourent. D’où cette focalisation sans cesse changeante, cette balance toujours refaite entre la zone d’écoute, sur-entendue, et la zone ambiante, sous-entendue.

Le monde auditif est donc à « présence variable » et il n’y a donc jamais de réalisme sonore dans l’absolu. Le point d’écoute change, zappe d’un objet à un autre, s’immobilise en oblique, retourne vers le même11.

En fait, l’attention prend en compte les éléments dont elle a besoin pour gérer la compréhension des éléments en devenir : elle valorise un emplacement (augmentation de la vigilance sur un élément provisoirement calme ou silencieux), elle hausse la présence d’une source pour en examiner tous les détails (accroissement de la netteté), elle atténue un son auditivement gênant (diminution partielle de l’effet de masque), elle oublie durablement un bruit jugé peu pertinent, elle surveille obliquement un élément momentanément secondarisé. En filigrane, on aperçoit ici ce que seront les efforts du perchiste pour imiter les mouvements de l’attention (en se faisant à la fois “chasseur de papillons et calligraphe”, selon l’expression de Christian Canonville).

C’est ainsi qu’un évènement auditif discret, de faible intensité, peut prendre une valeur de signal, alors qu’il reste peu saillant (perceptivement). Un son quelconque, riche en percutantes inutilement répétées, peut au contraire ruiner l’écoute (effet de masque) jusqu’à l’agacement. Un évènement sonore moins agressif peut être contré ou ignoré, alors qu’il persiste en termes d’intensité ou d’encombrement spectral. Un son oblique, annonciateur d’évènements importants (son précurseur), peut attirer l’attention et relaxer l’élément principal qu’on vient pourtant de centrer. Un propos important, perturbé par une ambiance bruyante ou un bruit passager, peut inversement résister aux interférences (écoute forcée).

Finalement certains éléments sonores sont négligés (surdité attentionnelle), tandis que d’autres bénéficient d’une audibilité accrue (acuité de focalisation). Ce sera au mixeur, avec le mouvement des potentiomètres12, de simuler ces différentes présences, de les mettre en perspective et en mouvement, pour peu qu’elles aient été préparées dès la prise de son.

Des opérateurs mentaux (supra-auditifs) entrent alors en jeu avec leur compétence spécifique : linguistique/pragmatique pour la parole, bruitiste pour l’environnement, musicale pour le concert. Il est de la sorte possible de reconstituer les éléments manquants d’une phrase pertur… par le bruit amb… ou par une articulat… insuff.…te : c’est la restauration phonémique. Ou d’écouter plutôt l’intonation vocale, le phrasé et de détecter ainsi les intentions cachées des locuteurs. Ou de reconnaître un pas familier. Ou encore de suivre une ligne instrumentale dans un quatuor instrumental. Ce faisant, l’attention mobilise un grand nombre de ressources mentales, puisqu’elle cherche aussi à élucider le contexte, à saisir le jeu incessamment renouvelé des causes et des conséquences.

f/ l’intentionnalité et la mémoire

Autrefois (il y a longtemps : l’ORTF vivait encore), existait une émission où les preneurs de son amateurs pouvaient faire entendre à la radio les enregistrements de paysages sonores, de musiques vivantes ou d’activités collectives qu’ils avaient attrapés sur une bande magnétique avec leur magnétophone (genre Uher stéréo). On les nommait « chasseurs de sons » : est-ce parce qu’un chasseur à l’affût fait attention à tout, au delà des consignes qu’il se donne, ou est-ce grâce au silence qu’il s’impose ? Est-ce parce que le gibier n’est pas facile à attraper ? Je ne saurais dire.

Par contre, ce qui est certain, c’est que l’écoute procède de l’intentionnel, puisqu’elle dépend des connaissances posées sur la situation ou prêtées aux personnes, ou même des consignes que l’on se donne. Les recherches actuelles en psychologie accordent une extrême importance au “set” ou préparation contextuelle, qui semble orienter les mouvements de l’attention en fonction de la situation.

Chaque contexte fait entendre des sons ordinaires et connus, des bruits anodins, une ambiance spécifique. Pour ne pas céder à la curiosité, l’auditeur ordinaire, qui n’est pas un chasseur de sons, recrute un certain nombre d’images prévisibles qui vont filtrer –inhiber– l’attraction réflexe. Ces contre-calques (profils, timbres, formants) venus de la mémoire auditive s’insèrent dans la chaîne attentionnelle, court-circuitant toute distraction et éteignant les surprises inutiles.

Inversement, certains sons –guettés ou espérés– s’installent sous forme de calques dans un horizon d’attente : ils n’en seront que plus facilement détectés dans le fond sonore, plus rapidement sélectionnés. En s’adaptant au données et au contexte, le “preset” mental nous aide à attraper l’information pertinente, à la détecter rapidement. On croira même parfois entendre certains sons, tellement on a envie qu’ils arrivent.

Pour autant, ces calques et contre-calques n’empêchent nullement la saisie de sons improbables ou inattendus. L’activité réflexe peut alors reprendre momentanément son rôle de surveillance omnidirectionnelle du territoire, dans la mesure où l’élément imprévu ne saurait être ignoré, ne serait-ce que pour prendre le temps de l’identifier.

Je pense qu’on entrevoit ici le pouvoir de la bande-son dans l’avancée d’un film : celui de créer de l’attente (on voit les choses arriver) en même temps que de proposer des surprises (elles surgissent du off ou du in). Celui d’entretenir la tension interne du récit, de faire vivre au spectateur un parcours intérieur par la mise en jeu permanente du prévu et de l’imprévu, activité sans laquelle l’ennui et le sommeil de la pensée gagneraient probablement du terrain.

La préparation affective joue un rôle comparable : certains sons jugés agaçants ou dangereux sont refusés ou au contraire surdimensionnés dans une présence insistante, redoutable. D’autres, agréables ou désirables, se trouvent embellis et même accueillis au plus profond de l’imaginaire. En somme, l’auditeur ordinaire tout comme le spectateur interagissent continûment en faisant du montage entre leurs perceptions externes et leurs attentes internes. Un tel aller et retour dirige en temps réel la focalisation.

Il est évidemment impossible de se représenter une situation sonore d’un seul coup, instantanément. Chaque instant renvoie en effet aux données précédentes, tout en se profilant sur les données suivantes, emportant le sens dans un déploiement sans fin. L’ensemble des indices extraits et reconnus vient confirmer ou infirmer certains aspects déjà anticipés, ouvrant sur de nouvelles phases prévisibles, de nouvelles postulations. La compréhension progresse ainsi par accumulation d’actes perceptifs ponctuels, par amoncellement. A tout moment, la scène sonore se construit en gardant la trace des profils passés et en avançant l’ébauche des profils à venir. Mais la trace s’évanouit, tandis que l’ébauche reste incertaine. C’est pourquoi chaque séquence de film a besoin d’autre chose qu’une simple captation passive (de type reportage), assez aléatoire au niveau des éléments entrants et sortants. Daniel Deshays parlerait plutôt d’une recomposition active, en plusieurs couches, d’événements temporels que l’on allonge ou que l’on resserre, délibérément.

Aussi bien, la perception de la bande-son apparaît-elle comme un processus inférentiel13, une succession d’essais où se confrontent anticipations, hypothèses et vérifications, une succession de traces aussi qui persistent en surimpression, suspendues comme des filigranes. Il n’y a donc pas de représentations définitivement figées –univoques– dans le monde mouvant des évènements auditifs. De nombreuses connexions se font et se défont dans la mémoire, suivant en cela les modulations du flux sonore, mais aussi les modifications du champ visuel. C’est évidemment au montage et à la mise en scène de les organiser, de les susciter.

Toute figure auditive –aussi imprécise soit-elle– se raccroche pourtant à un écoulement précis, tout en se rattachant à un répertoire connu d’évènements plus ou moins longs, ayant leur durée propre. Si la figure visuelle peut se contenter de l’immobilité, d’un « temps zéro » (comme en photo !), la figure sonore ne supporte ni accéléré ni ralenti, ni hiatus temporel, mais s’accommode parfaitement d’un « espace zéro », unidimensionnel (comme en mono !).

Le son intermittent, par des ancrages sporadiques ou durables dans l’image, par des contaminations énergétiques rythmées, vient de la sorte compléter les inférences visuelles, ou les relancer dans d’autres tensions, d’autres postulations. Je pense à la scène de la réverbération, mesurée au pistolet, dans La Ville Louvre, de Nicolas Philibert : le rythme des détonations successives, salle après salle, finit par allonger le temps réverbéré au delà du possible, jusqu’à rencontrer l’idée d’un temps venu jusqu’à nous, le temps des civilisations disparues mais encore figées dans la pierre des colosses pharaoniques.

L’instant présent n’est finalement visé et interprété qu’à travers ce qui n’est plus ou ce qui n’est pas encore. Le montage a ce pouvoir d’inventer et d’écrire des implications, de faire rencontrer presque instantanément des éléments souterrainement liés, mais ordinairement séparés dans le temps, éparpillés dans l’espace. Cela étant, dans la vie comme au cinéma, la mémoire auditive reste poreuse : traces, ébauches et filigranes –aussi nombreux soient-ils– n’ont pas tous le même poids, la même durée de vie. Les filigranes sont plus ou moins insistants, plus ou moins redessinés, les esquisses sont diversement crayonnées.

g/ le désir et l’action

C’est par le désir (le désir de voir ou d’entendre, d’aimer ou de comprendre, de s’identifier ou de se démarquer) que le spectateur s’installe dans un documentaire. Le sujet du film l’intéresse, ce n’est pas un pur divertissement, une évasion. Chacun est curieux aussi de la façon dont le cinéaste va s’y prendre : de son degré d’invention, de la qualité de son scénario, de sa direction de spectateur. La pulsion de voir se mêle à la pulsion de savoir. On se reconnaît dans les personnages ou les situations, qui, sans être forcément les nôtres, nous concernent directement ou indirectement. On se projette avec ses affects, on partage les joies et les souffrances des personnages, on s’interroge sur les causes et les remèdes des situations. Comme les émotions, les enjeux nous mobilisent.

La mémoire est donc convoquée tout au long de la projection (52 minutes ou plus), pour un temps recomposé, resserré, intensifié, émouvant. Tout communique en effet dans cette mémoire à court terme : les personnages, les situations, les conflits. Chacun peut y faire son propre montage, y entretenir délectations ou irritations, se laisser prendre au flux des informations et des émotions. Certaines idées surgissent, d’autres s’évanouissent ou se transforment. On aime ou on déteste. On forme des hypothèses, on filtre, on évalue. On retient, on feint d’oublier. Ou alors on se rappelle trop bien. C’est que l’émotion polarise le champ de conscience sur l’objet qui nous préoccupe, sciemment ou inconsciemment, comme pour mieux lui dessiner une trajectoire, un retentissement.

Qu’à donc à faire le spectateur durant la projection ? Sinon construire un scénario intérieur, alternant les images visuelles et auditives de l’écran avec celles du monde mental, plus volatiles ou plus tenaces… Tracer des lignes conductrices ? Errer dans ses souvenirs ? Se rattraper au film ? Les insistances de la mémoire, les brumes de l’oubli, les décrochages de l’attention ne sont peut-être pas tous manœuvrés depuis l’inconscient freudien ou pilotés par le préconscient (cognitif, mémoriel) mais ce qui est sur, c’est que le spectateur voyage dans le film avec un double scénario : celui des données externes, des agencements de montage, des correspondances proposées entre les images visuelles et les images auditives ; celui des réminiscences internes, des associations spontanées, des raisonnements intérieurs. Un double scénario qui unit ou oppose le sous texte du film au vaste écran de la mémoire et des oublis, des adhésions et des refus.

Il y a au fond comme un duel toujours possible entre spectateur et cinéaste autour du sujet traité par le film. Si le film va à l’encontre des idées répandues (préalablement idéalisées comme vérités communes), le cinéaste s’expose peut-être aux réactions de défense du moi, lequel n’aime pas trop reconsidérer ses présupposés, dans la mesure où ceux-ci soutiennent un ego généralement fragile, assurant un étayage provisoire au très délicat et très chatouilleux trio croyance/savoir/ignorance (trio qui est notre lot). La mise en scène peut essayer de dissimuler son discours en s’abritant derrière celui des personnages qui mèneraient alors leurs actions, plan après plan, comme s’il n’y avait ni tournage ni montage, dans une sorte de transparence narrative. A moins qu’elle ne propose au spectateur de s’ouvrir à l’intelligence du monde, en essayant de le chercher là où il est, sans le brusquer, mais en le déstabilisant néanmoins, ce qui ne semble pas si facile.

Pour terminer ce parcours à travers l’audition, je souhaiterais conclure par une assertion qui peut surprendre ; personne n’entend jamais exactement les sons qu’il produit ! De fait, l’activité motrice modifie grandement la perception que l’on a des sons obtenus en bougeant, travaillant, parlant, marchant… etc. Un menuisier n’entend pas exactement l’impact du marteau sur les clous, un bricoleur n’est pas gêné par le bruit de sa perceuse, un automobiliste ne sursaute pas quand il klaxonne, un type pressé n’entend pas le bruit qu’il fait en courant sur un plancher sonore, etc.

Les neurobiologistes ont une explication : chaque fois qu’un geste voulu va produire un son gênant (choc, fracas, grincement, chute…), le cortex prémoteur envoie automatiquement –sauf volonté particulière– une copie de l’enveloppe biodynamique de ce geste au cortex auditif, copie qui est aussitôt traduite en enveloppe acoustique (profil énergétique/temporel du son). C’est cette enveloppe qui, comme un contre-calque soustractif, s’interpose pour atténuer et arrondir ce que l’oreille va capter. L’éclat sonore est en quelque sorte assourdi préventivement, même si le son est émis en léger différé, dans la conséquence d’un acte (par exemple, claquer une porte) ; l’impact attendu est pareillement contre-calqué, sur la base d’expériences antérieures ou récentes. En sorte que le son entendu se trouve sensiblement aplati ou amorti par l’intention en acte, un peu comme s’il se trouvait relégué hors du champ de l’attention. Cela n’est pas sans conséquences, notamment lorsque l’on travaille sur du son en train de se faire ou déjà fait.

Revenons à la pratique du documentaire.

Lorsque l’image dit « coupez ! » le son a envie de dire « je n’ai pas fini, çà continue »… il y a comme un conflit d’intention entre l’image qui a son début et sa fin, et le son qui a un autre début, une autre fin, car le preneur de sons travaille à la fois en et hors champ, sur la durée propre des évènements sonores qui ne sauraient être coupés, en raison de leur utilité au montage.

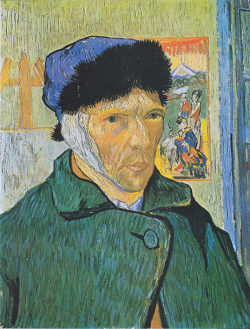

Van Gogh a perdu le même jour son frère et son ami peintre, croit-il… Des heures creuses, dont on ne sait rien, et ce geste fou : devant son miroir, en fin de soirée, Vincent se tranche l’oreille avec son rasoir. Il pisse le sang, l’éponge avec des draps, puis traverse la ville vers la « maison de tolérance n°1 » où il demande « Rachel », une jeune femme qu’il connaît, à qui il remet le lobe de son oreille enveloppé dans du papier journal. Elle tombe dans les pommes en ouvrant le paquet.

Quand un « acteur du réel » parle au cinéaste, entend-t-il vraiment le son de sa voix, ou plutôt ses intentions, ou seulement le texte qu’il veut faire passer ? A quel moment lâche-t-il assez prise pour faire la synthèse des trois, trouver le ton juste, les mots exacts ? Comment délivrer les vraies intentions, accéder au flagrant délit de sincérité ?

Quand l’ingénieur du son réécoute (au casque) la prise qu’il vient de faire à la perche (sans casque), quelles sont les consignes qu’il se donne pour évaluer la justesse des sons enregistrés ? La voix est si proche du cerveau que tout s’entend en termes de rendu, d’intentions bien ou mal jouées, trop appuyées ou à peine données. De même, la qualité esthétique des matériaux (percussions, frottements, formants et résonances) entre en jeu non seulement pour souligner et clarifier la cause ou la conséquence des énergies en mouvement (l’écoute causale en laquelle nous enfermons si volontiers le déroulé d’un son) mais aussi pour réveiller des sons cousins, des mondes enfouis, des images furtives.

Lorsqu’un pianiste joue, écoute-t-il plutôt ses intentions (préfiguration de l’expression) ou entend-t-il le son réellement émis par l’instrument ? Peut-il se concentrer sur le son du piano sans perdre le fil prémoteur –toujours un peu anticipé et élargi– de l’expression musicale ? Ne doit-il pas se réécouter pour savoir ce qu’il a effectivement joué ?

Lorsqu’un monteur-son a une idée (son off, détail associé, soulignement sonore, chevauchement…) écoute-t-il principalement son idée ou le mélange sonore réellement obtenu ? Comment évaluer les sons dans un temps reconstruit, recomposé ? S’agit-il seulement de désigner ou souligner le visible par de l’audible ? Comment rythmer le montage horizontal (les correspondances instantanées entre différents sons, directs ou ajoutés, et l’image) et aussi bien le montage vertical (la succession des images auditives en ou hors écran) ?

Lorsqu’un ingénieur du son mixe le film (écoute – analyse – traitement immédiat au potentiomètre), le travail en temps réel l’oblige à partager son attention entre les gestes du mixage (présent perceptif) et la mise en scène (créer un continuum scénique incluant un présent très élargi). Peut-il contrôler auditivement ce qu’il fait tout en pré-entendant ce qu’il a encore à faire et en le reliant à ce qui vient d’être fait ? C’est certainement en travaillant par petites touches successives, en se réécoutant, qu’il peut affiner progressivement la balance sonore.

C’est que le mixage travaille à l’échelle de la séquence entière, en proposant au spectateur une partition attentionnelle, une stratification figures/fonds. D’une part, on suit clairement les sons jugés importants, tels que voix et effets ; d’autre part, on joue de l’ambiance, on la fait vivre, sans pour autant laisser ces fluctuations subtiles se faire remarquer par le spectateur14. On arrange un climat acoustique circonstanciel en l’atténuant, en le simplifiant, le plus souvent pour des raisons d’intelligibilité. Fonds d’air, bruits adventices, sons passagers peuvent cependant muter subitement en sons principaux, selon les besoins de la mise en scène.Dans tous les cas, le mixeur affronte l’inter-masquage, à savoir : le délicat réglage entre émergence et enfouissement des sons.

Les sons forts cachent les sons faibles (notamment ceux situés immédiatement au dessus dans l’échelle des hauteurs), les percutantes couvrent les sons tenus, la réverbération brouille l’intelligibilité ! Le mixeur –comme le compositeur15 – dispose néanmoins de plusieurs parades dès l’instant où l’on a recours au multipistes, aboutissement de la prise de sons fractionnée. Il peut pondérer les sons forts (potentiomètres de mélange), filtrer les formants les plus énergétiques des sons masquants (correcteurs paramétriques), compresser les percutantes à front raide (compresseur/limiteur) et atténuer ainsi le masque-réflexe16.

A cet égard, l’étalement spectral des sons sur les dix octaves de l’audition est décisif en monophonie. Une contrebasse ne saurait masquer une flûte ! Tandis qu’un bruit de circulation, une chute d’eau (bruit large bande) masquent tous les sons (« chuuut ! »). Aussi le choix des timbres et des hauteurs sonores devrait-il se penser dès le tournage, en se rappelant que les sons percussifs intenses et larges de spectre (marteau-piqueur, mobylette, camion, etc.) sont redoutables pour les voix (fréquences médiales). De même, l’étagement des plans sonores est un moyen commode de favoriser l’accommodation auditive sur telle ou telle source, selon sa distance, et de la distinguer parmi d’autres sons simultanés. Enfin, il est toujours possible de mixer des sons intermittents (en pointillés) avec un son continu : on est là dans une situation comparable à une scène qui serait observée derrière un ou plusieurs grillages. Tant que le maillage est léger, tant que le fil n’est pas trop gros, il y a encore quelque chose à voir au delà.

Au total, il semble bien que dans la production humaine de sons (voix, bruits, instruments de musique, et même mixage) l’interaction sensori-motrice modifie grandement la perception auditive, en mêlant intention gestuelle et résultat auditif ; sur le mode soustractif en cas de bruit gênant (il n’est pire sourd que celui qui ne veut pas entendre), sur le mode additif dans le cas de sons voulus (effet placebo : le son réel est embelli ou arrangé par l’intention).

Sans aucun doute, les professionnels du son, aguerris par la pratique à des automatismes solides et nombreux, se rendent disponibles pour une écoute plus lucide, plus pointue, affranchie des projections intentionnelles faciles, de la confusion naïve entre vouloir et obtenir.

Reste que l’œuvre doit passer –mûrement intentionnée mais toujours possiblement conflictuelle– à travers plusieurs personnes, étirée et retenue, contrainte et libérée, entre contrôle instrumental du praticien et lâcher prise artistique de l’interprète.

Entre science et art, entre pratique et esthétique, le dialogue ne saurait –ne devrait– s’interrompre.

- En monophonie, si le projecteur est le haut-parleur, les écrans de réception ne sont autres que les tympans ! Recevant à gauche et à droite les mêmes vibrations (le même stimulus), le cerveau ne peut plus spatialiser les sons, condition préalable à tout « nettoyage » auditif (BMLD) et même à toute focalisation de l’attention (ILD) vers telle ou telle source.

- Le son échappe au découpage en plans. Il est du reste mixé pour la séquence : il s’agit le plus souvent de simuler l’attention auditive et sa partition [une zone écoutée, une ambiance à l’entour] en colmatant les ellipses cachées dans les cuts, entre les plans, pour rétablir un continuum apparent, malgré le resserré du temps.

- Mais aucun foyer sonore n’est à même de se comparer au soleil comme source d’énergie ! Combien de térawatts ? je ne saurais le dire. Quand on sait l’énergie acoustique d’un avion au décollage (30 kW) ou celle d’un piano (0,3 watt)…

- D’où cette disparité parfois ressentie entre le voir et l’entendre : une étendue apparemment immobile (les sources sont cachées à la vue) peut donner lieu parfois à un paysage sonore intense, voire continûment changeant…

- Les plis de l’oreille externe provoquent des interférences constructives et destructives (filtrage en peigne) qui varient selon la provenance des aiguës.

- Ce conduit semble adapté à la saisie lointaine des cris du bébé, dont les fréquences vocales sont particulièrement prégnantes, même à bonne distance…

- Les compositeurs, les mixeurs jouent du reste constamment de l’effet de masque. Et aussi bien les industries électroacoustiques, qui compressent elles aussi les données (ATRAC, MPEG) en s’abritant sous le même principe.

- Pierre Schaeffer a été, avec Pierre Henry, l’initiateur de la musique concrète, juste après la deuxième guerre mondiale. Il a –entre autres– théorisé et classé les composantes internes des objets sonores, jusqu’alors mal connues.

- Pour la TMMP, c’est parce que chaque auditeur est aussi un locuteur, qu’il lui est possible de retrouver, à travers la surface acoustique, la structure articulatoire sous-jacente. L’analyse des sons (et des mouvements qui les causent) repose donc sur la connaissance implicite des règles motrices qui organisent les gestes. Selon Jean Decety, chercheur en neurosciences, « un même réseau neuronal (dans le cortex prémoteur) s’active lorsque je vois autrui agir, lorsque j’imagine cette action et lorsque j’agis moi-même » [cf. « Mouvement réel, mouvement imaginé » in Science & Vie N°204, hors-série, septembre 1998]. Ce sont les fameux « neurones-miroirs », déclencheurs d’inférences.

- Le passage du signifiant (assemblage de qualia) au signifié (représentation générique) dépend forcément des expériences, de l’habitude, de la pratique sociale de tout un chacun. D’où cette diversité, maintes fois observée, dans l’écoute des spectateurs : certains sons restent incompris, d’autres déclenchent des souvenirs, des affects.

- Plusieurs flux auditifs peuvent coexister dans une même scène auditive, sans que la focalisation sur l’un d’eux n’altère la qualité auditive des autres. Des filtres attentionnels (filtres en peigne multi-bandes) rehaussent (jusqu’à 18 dB) la présence de la cible en s’adaptant à ses formants acoustiques. Mais ce filtrage supra auditif laisse intact les apparences sonores, il ne modifie que la « présence à soi » des choses.

- Contrairement au montage-cut (très rapide) des images, le mixage monophonique scénographie assez mal les données auditives, en raison de finalités opposées au plan des vitesses : en tant que simulation d’une scène réelle, il s’interdit le mouvement rapide et artificiel des niveaux, s’oblige à respecter les variations naturelles des flux auditifs ; en tant que simulation de l’écoute attentive d’un auditeur, il se force aux mouvements instantanés du zapping auditif, et tend à les imiter par de prestes changements de niveaux. Les mouvements de potentiomètres existent, mais ils se dissimulent ou se codifient dans un compromis : un « accéléré » acceptable par la perception, un « ralenti » admissible par l’attention.

- Inférer : imaginer la suite, élargir le présent actuel en le reliant aux causes passées et aux conséquences futures.

- La surimpression multiple et invisible (impossible à l’image), est de facto l’artefact majeur du son, tandis que le cut, le changement d’axe et de distance (peu utilisé au son, trop perturbant) est l’artefact qui organise la bande image.

- Pour maintenir la pulsation rythmique audible, Maurice Ravel rajoute une caisse claire au milieu de son Boléro ; Gustav Malher, dans ses symphonies, fait parler les clarinettes au plafond pour les rendre moins présentes… A chaque instant, le compositeur décide du nombre d’instruments, de la densité des timbres, et de la nuance (ppp à fff) dans laquelle ils s’expriment.

- Le masque-réflexe apparaît à l’occasion d’un son soudain. Tintamarre, coup de feu, chute d’un objet, puis…silence. L’oreille, habituée au bruit ambiant est surprise : ce n’est qu’après un petit instant qu’elle retrouve le fond sonore. Et ce temps de recouvrement (masque-réflexe de quelques dixièmes de secondes, voire plus) est d’autant plus long que le son a été violent. Celles et ceux qui ont connu le disque vinyle et ses rayures ont éprouvé le masque réflexe : il a fallu souvent se résigner à jeter un disque trop abîmé.